【学术科研】计算所NLP课题组2篇论文被ICLR 2023接收

2023年1月,自然语言处理组2篇论文被ICLR 2023接收。ICLR 2023的全称是the 11th International Conference on Learning Representations, 由位列深度学习三大巨头的 Yoshua Bengio 和 Yann LeCun 牵头创办, 2013 年开始每年举办一次,是深度学习领域的顶级会议之一。在 Google Scholar 的学术会议 / 期刊排名中,ICLR 目前排名第 9 位。ICLR 2023将于2023年5月1日-5月5日在卢旺达首都基加利举办。

被录用论文的简要介绍如下:

1. 论文题目:Hidden Markov Transformer for Simultaneous Machine Translation

论文作者: 张绍磊,冯洋

论文概述: 同步机器翻译(Simultaneous Machine Translation,SiMT)在接收源序列的同时输出目标序列,因此学习何时开始翻译每个目标词是同步机器翻译的核心挑战。然而,在许多可能的开始翻译时刻中学习最佳时刻并非易事,因为开始翻译的时刻总是隐藏在模型内部,我们只能用观察到的目标序列来监督SiMT模型。在本文中,我们提出了隐马尔可夫Transformer (Hidden Markov Transformer, HMT),它将开始翻译的时刻视为隐藏事件,将目标序列视为相应的观察事件,从而将两者组织为隐马尔可夫模型。 HMT对多个可能的开始翻译时刻进行显式建模,用作候选隐藏事件,然后选择一个生成目标词。在训练期间,通过在多个开始翻译时刻上最大化目标序列的边际似然,HMT学会在可以更准确地生成目标标记的时刻开始翻译。多个SiMT 基准上的的实验表明,HMT优于强大的基线并实现了最先进的性能。

2. 论文题目:Fuzzy Alignments in Directed Acyclic Graph for Non-autoregressive Machine Translation

论文作者:马铮睿, 邵晨泽, 桂尚彤, 张民,冯洋

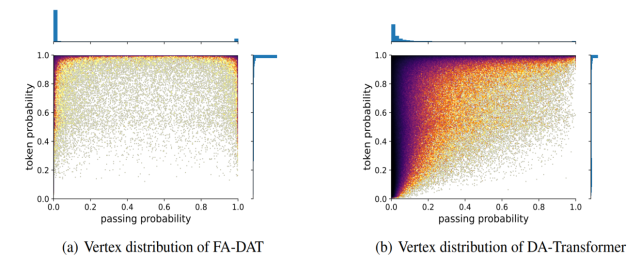

论文概述:非自回归机器翻译(Non-autoregressive Translation, NAT)显著降低了用户等待译文的延迟,但因为语言映射的多峰分布特性,往往性能较差。为此,一些研究者尝试将有向无环图(Directed Acyclic Graph, DAG)结构引入NAT系统,试图通过DAG建模输出字词之间的依赖来缓解多峰分布问题。这种系统一般通过极大似然估计的方式进行模型参数学习,以负对数似然(Negative Log Likelihood, NLL)作为损失函数。尽管上述方法取得了一定的成功,我们发现NLL隐式地要求了目标译文字词与DAG节点之间存在严格对齐关系,弱化了DAG学习多峰分布的能力。在本文中,我们考虑DAG中所有可能的路径与参考译文之间均存在某种模糊对齐关系。我们设计了一个模糊对齐指标以衡量图与译文的匹配程度,并以最大化该指标的方式进行参数学习。大量实验表明我们的方法显著地改善了NAT系统的翻译质量,在多个基于原始语料的NAT翻译任务上达到了最先进的性能。